在打造个性化形象的同时,Rokid还在效果呈现和所需资源消耗方面进行了平衡。通过采用更少的网格面来表现,Rokid自研XR数字人技术大大降低了资源消耗和硬件负荷,以便实现在算力有限的硬件上,如AR眼镜、手机端等同时驱动大量数字人,进而推动数字人在多人在线的同屏社交场景使用。

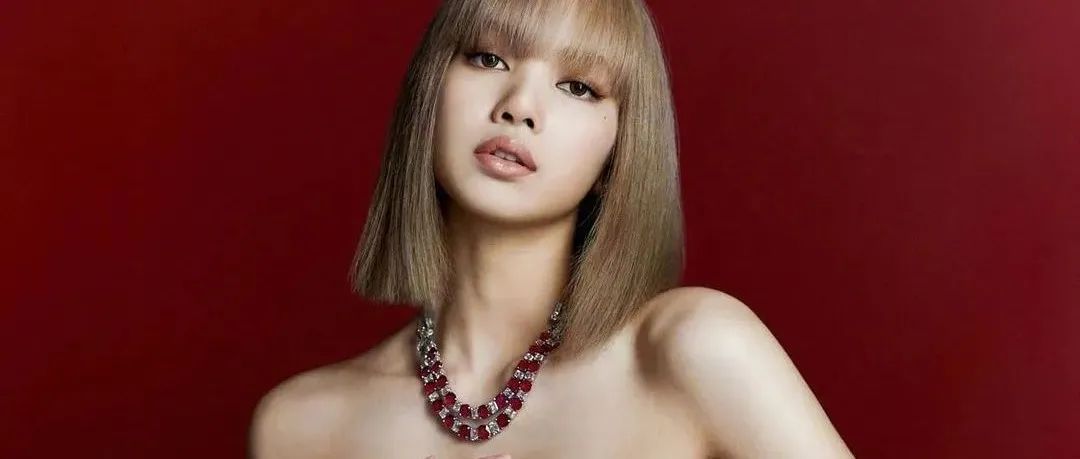

目前,Rokid自研XR数字人已基本满足亚裔人群特征。未来Rokid还将推出更多的五官分类组合和动作,更多样的肤色、发型、发色以及不同地域风格的服装、道具等,让不同的国家和地区的用户都可以创作出具备独有特征、妆容、服装以及道具的数字人。

数字人的模型有了,该如何让数字人动起来?

目前,业内一般通过面部捕捉的方式来采集面部动画的数据,从而让数字人“动”起来,例如ARkit,Faceware,DynamicXYZ等,就是通过捕捉演员的表情动作,然后再映射到高精度的3D角色面部上。

面部捕捉的方式虽然解决了数字人表情灵动的问题,但在现实应用中,如AR眼镜等设备并不支持面部捕捉。同时,线上会议等场景还需要数字人能实时生成动画,面部捕捉的方式并不适用。因此,让数字人的表情帧和声音帧同频,嘴部动画的实时生成就成为了行业难题。

对此,Rokid技术团队拿出了最新研发成果——ASR(自动语音识别技术)到音素+bs系数的音频驱动方案。

通过ASR(自动语音识别技术)到音素+bs系数的音频驱动方案,无需额外的摄像头对表情动作进行捕捉,Rokid自研XR数字人就能实现口型与表情动作与真人同步匹配。

同时,不同于业界目前普遍采用的ASR(自动语音识别技术)将语音识别成文字,然后通过TTS(从文本到语音)输出音素+bs系数的音频驱动方案,Rokid自研XR数字人采用的音频驱动方案,基于多年积累的ASR技术,省掉了将语音识别成文字,再由文字输出音素的环节,在保持识别准确度不低于行业标准的情况下,以更短的识别路径、更低的延迟(相对业界降低延迟30%)、更低性能要求的驱动方案实现了数字人声音帧和表情帧的绝对同步。

此外,在移动端,Rokid自研XR数字人解决方案单帧处理时间实现了低于3ms/frame,且CPU占用率能保证的在10%以下。

本文来自微信公众号“Rokid”(ID:Rokid1115)。大作社经授权转载,该文观点仅代表作者本人,大作社平台仅提供信息存储空间服务。