在前面的文章《Stable Diffusion官方发布最新2.0版本》中,我们介绍过SD2新增了一个功能是Depth2Image图像扩散模型。

下面是使用Depth2Img后的效果。

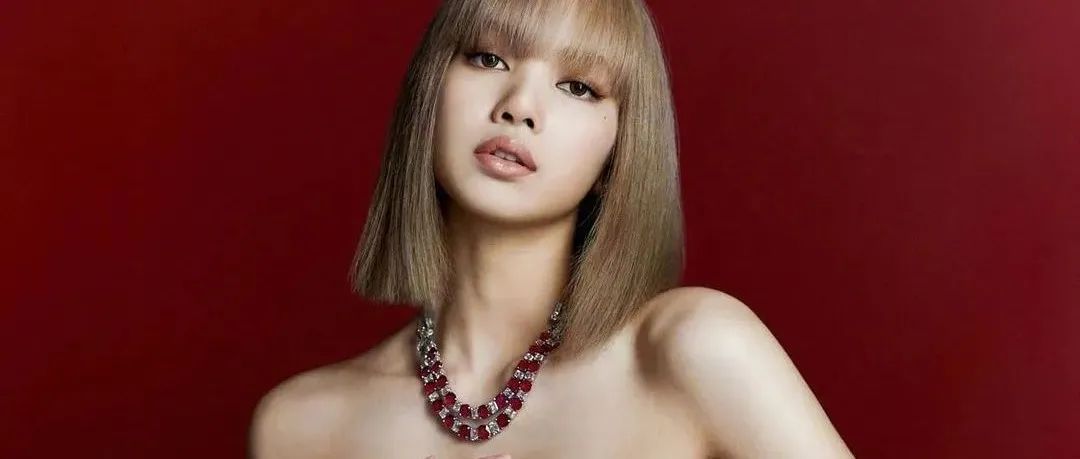

下面这个示例我们再改变画面的风格,从真实人物改编成动漫风格,同样保持了图像的空间感和人物姿势的统一。

示例二:动物

第一张是初始图,后面三张使用Depth2Img重新绘制,在保持空间关系不变的情况下,可以重新设计室内布局、风格。

第一张为原始室内图,后三张为使用深度图改变提示语的效果,室内的整体风格都发生了改变,但空间关系仍可以保持不变。结合前面的一篇文章《Ai取代室内设计师?背后的技术是什么样的?》再看看,这个新的功能应该可以对室内效果图的生成带来更多的改变。

从上面的使用体验来看,Depth2Img有些像Inpainting和Img2Img的结合体,既能从初始图像开始扩散生成大部分内容,同时又能根据深度图,对局部图像使用Inpainting进行了改变重绘。有兴趣的朋友可以体验一下Depth2Img这个新的模型功能。

推荐阅读以下AI绘画内容:

对公众号最好的支持就是

转发、点赞、关注、打赏

本文来自微信公众号“今说新语”作者:穿行者2049(ID:Bitgenius)。大作社经授权转载,该文观点仅代表作者本人,大作社平台仅提供信息存储空间服务。