但Stable Diffusion的这个新魔法并不仅仅能做到这里就止步,前些日子谷歌发布了一个新的论文,通过对 Imagen 模型进行微调,从而实现了将现实物体在图像中真实还原的功能。相关论文以《微调文本到图像扩散模型,以实现主体驱动生成》(DreamBooth: Fine Tuning Text-to-Image Diffusion Models for Subject-Driven Generation)为题发表。

这个名为 DreamBooth 的模型是一种新的文本到图像“个性化”(可适应用户特定的图像生成需求)的扩散模型。另外,虽然 DreamBooth 是在 Imagen 的基础上做的调整,但研究人员在论文中还提到,他们的方法也适用于其他扩散模型。

只需几张(通常 3~5 张)指定物体的照片和相应的类名(如“狗”)作为输入,并添加一个唯一标识符植入不同的文字描述中,DreamBooth 就能让被指定物体“完美”出现在用户想要生成的场景中。

在谷歌的宣传文字中是这样说的:它就像一个照相亭,但一旦拍摄对象,无论你的梦想带你去哪里,它都可以被合成......

可能很多人没有意识到,我们昨天介绍的训练Stable Diffusion的方法,正是同样的方法,也就是说,我们可以实现谷歌论文中所宣传的各种应用方式。

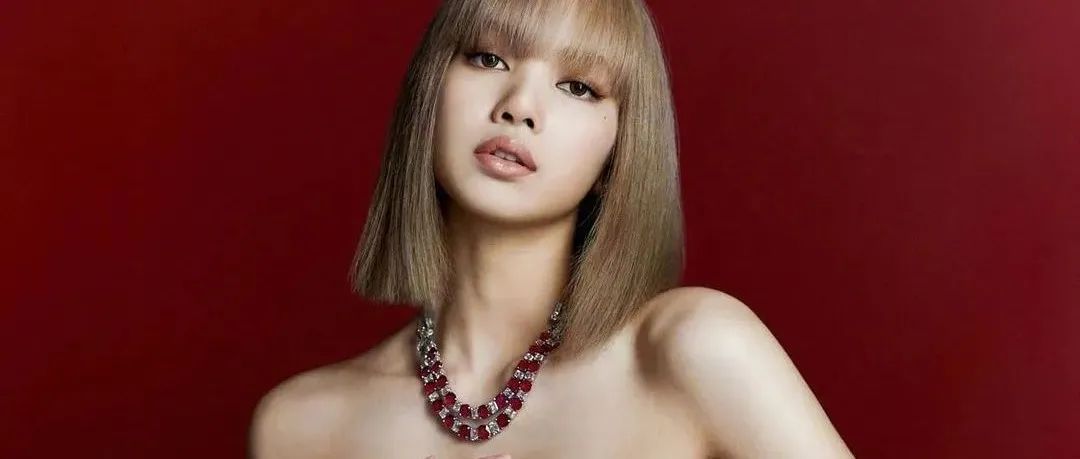

我给Stable Diffusion输入了一个女明星的五张人像照片进行训练,随后用训练后的模型完成谷歌论文中的各种实验。下面所有内容都先展示谷歌的应用实例,然后展示我训练后的模仿效果。(出于版权安全考虑,使用较低的steps步数,人物面部都比较模糊)

一、环球旅游

现在你也可以让你自己的照片、你的宠物、你的玩具出现在世界各地。

二、走入世界名画

还可以让你输入的内容作为演员,艺术再现各个名画中的风格。

三、换个角度看她

还可以指定你输入的对象用指定的视角展现自己,如侧脸。

四、魔法变身

修改你输入对象的各种属性,如颜色。

给你输入的对象更换服装、帽子等等。

五、可能的负面影响

Stable Diffusion的这个新能力,或者说AI的这个新能力,旨在为用户提供在不同背景下合成个人主题(动物、物体)的有效工具。它可以使用户能够更好地重建其理想的主题。但是反过来说,恶意方也可能会试图使用这些图像来误导观众,模糊现实与虚拟的界限,这是一个可预见的问题。未来对这个能力的研究,特别是对个性化训练AI的研究,必须慎重或者避免用真人数据训练AI。

做完这些试验,我还是挺庆幸Stable Diffusion的这个模型目前还有所限制,无法生成更高分辨率的图片,采样数据也比较少,只需提供3-5张图片,所以面部细节其实不够多。如果面部细节和其他题材一样清晰,影响就太恐怖了。不过最后一张AI画的好像也足够清晰了,我都忘了用的是哪个明星照片训练的了。。。以后还是用玩具或宠物训练好了。

这篇文章就到这里,码字不易,有收获的朋友欢迎转发、分享、打赏支持。

本文来自微信公众号“今说新语”作者:穿行者2049(ID:Bitgenius)。大作社经授权转载,该文观点仅代表作者本人,大作社平台仅提供信息存储空间服务。