上期介绍了 AI 生成内容的神器 playgroundai ,不仅支持用户0学习成本创作图像,也提供了简易上传底图蒙版,指定AI生成区域的功能。

Mixlab

小杜

近期谷歌研究与特拉维夫大学推出一种使用 “Cross-Attention Control” 方法,支持用文本多次编辑 “由文本生成的图像” 的新模型。

从文本生成图像,再利用文本进一步编辑修改生成图,可以预见下一代设计软件将会让设计的门槛极大的降低,全民设计师可能不再仅仅是一句口号了~

大规模语言图像模型

例如Stable Diffusion 通常很难仅通过单独编辑提示来控制,并且对于用户来说可能非常不可预测和不直观。大多数的现有方法需要用户输入一个底图,如果底图的形状或者画面布局不合适,则可能不会产生符合预期的结果。小杜

作者的方法使我们能够仅编辑文本提示来把控图像生成制作的过程,为基于文本输出操作的图片编辑应用程序开发铺平了道路。

作者也提供了不少功能应用的demo,例如通过替换单词进行局部编辑,通过添加规范进行全局编辑,或者控制其中一个词反映在图像的指定范围中。

带我们看下直观的效果?

Mixlab

小杜

本文展示了由文本控制生成图像的4种功能效果-

1.文本主体替换

2.文本主体修改变化

3.风格替换

4.风格权重修改

# 01 文本替换图像主体

小杜

项目提供了体验demo,感兴趣的同学也可以体验一下哦~

prompt-to-prompt.github.io/

我突然想到一个问题,现在AIGC技术发展得这么快,无论是生成内容的质量与格式、提示语学习的资源还是现有的AI产品功能,几乎都在爆炸式地增长,我们人类的判断力能跟得上AI的发展吗......

Mixlab

小杜

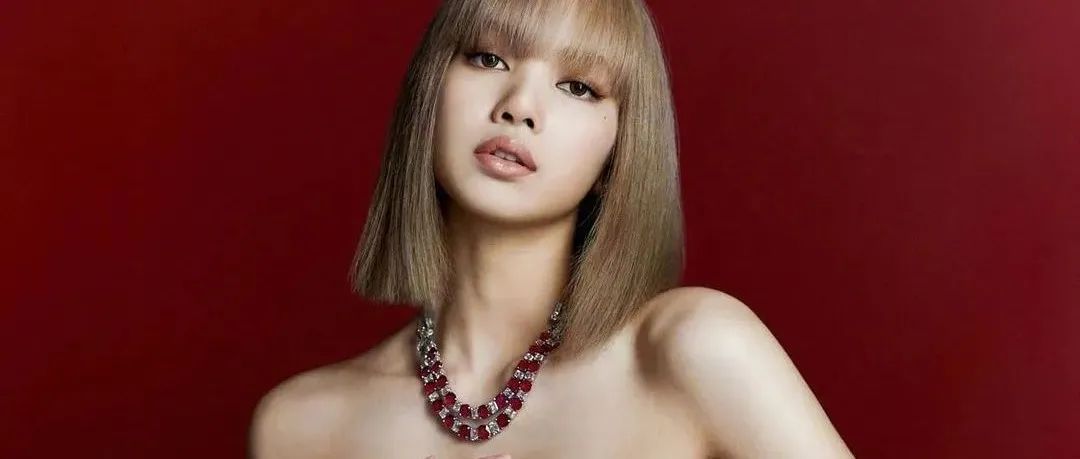

给你推荐一个 AI生成VS人类画师 判断问卷,绘画主题是最近比较火的动漫人物角色生成,我的得分非常不理想,45题只对了33个,AI的发展着实有点冲击我的认知上限了......

附上我差点没及格的问卷以及两个冲击我认知的AI画作......

docs.google.com/forms/d/e/1FAIpQLSdhEpBRnOwiFI-ieNKKu3Y0KcoFbd_ZWod1LeyoV6EEfY78HA/viewform?fbzx=8547340431228740851

opus

欢迎留言讨论,参与 AIGC 共创共建~

本文来自微信公众号“无界社区mixlab”作者:杜韦柯er(ID:mix-lab)。大作社经授权转载,该文观点仅代表作者本人,大作社平台仅提供信息存储空间服务。