本周是人工智能技术迅速发展的一周,GPT-4、Midjourney5、GEN-1分别代表了文本生成、图像生成和视频生成三个AIGC领域。前几天,我收到了GEN-1试用通知,但一直忙于Midjourney的新版体验,直到今天才体验了这个传说中的AI视频神器。

GEN-1是Runway公司推出的一款新型视频模型,能够改变视频或电影的视觉风格。去年,Runway公司曾合作开发了Stable Diffusion,现在又发布了名为Gen-1的人工智能模型。通过应用文本提示或参考图像中指定的风格,Gen-1可以将现有视频转换为新视频。

然而,对于普通用户来说,体验效果需要降低期望值,可以将其视为去年Disco Diffusion刚推出时的效果。尽管从官方发布的一些演示视频来看,技术无疑非常棒,也能够实现非常精彩的效果,但是目前面向测试用户的服务存在许多限制,导致完成的视频还比较粗糙,例如视频时长只有3秒,分辨率和流畅性都很低。不过,用户可以体验一下他们产品未来的一个实现理念和流程。

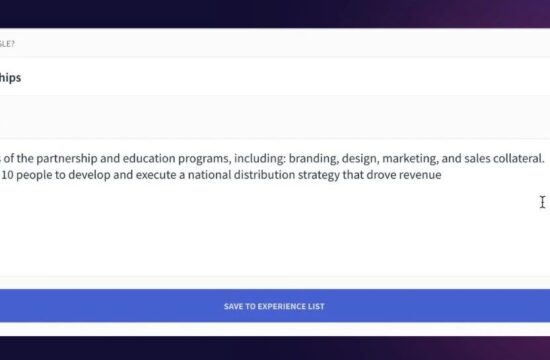

本周,前期申请的部分用户将收到使用权限,但申请通过后并不会收到邮件通知,需要自己查看Discord的官方频道,如果能看到下面的频道,就表示通过了测试申请,可以开始使用。

2、提示语

目前看提示语简短些就好,各种关键词对最终效果影响不大,重要的是风格要独特,例如城市夜景、燃烧、爆炸、夕阳等关键词就容易出效果,什么高清、细节等等就算了,这么低的分辨率也体现不出来。

--mask_mode_foreground true 只会影响前景主体而不会影响背景,效果看下面的视频,这个提示语是乐高小人跳舞,所以面部很差劲。

--mask_mode_background true 只会影响背景而不会影响前景主体,效果见下。

--subsampling 5 增加跳帧次数,相当于增加了视频长度,可以在视频生成后再在视频编辑软件中增加插帧。

本文来自微信公众号“今说新语”作者:穿行者2049(ID:Bitgenius)。大作社经授权转载,该文观点仅代表作者本人,大作社平台仅提供信息存储空间服务。